Se vuoi eseguire Large Language Models o LLM sul tuo computer, uno dei modi più semplici per farlo è tramite Ollama. Ollama è una potente piattaforma open source che offre un’esperienza AI personalizzabile e facilmente accessibile. Semplifica il download, l’installazione e l’interazione con vari LLM, senza dover fare affidamento su piattaforme basate su cloud o richiedere alcuna competenza tecnica.

Oltre ai vantaggi di cui sopra, Ollama è piuttosto leggero e viene aggiornato regolarmente, il che lo rende molto adatto per la creazione e la gestione di LLM su macchine locali. Pertanto, non hai bisogno di server esterni o configurazioni complicate. Ollama supporta anche più sistemi operativi, tra cui Windows, Linux e macOS, nonché vari ambienti Docker.

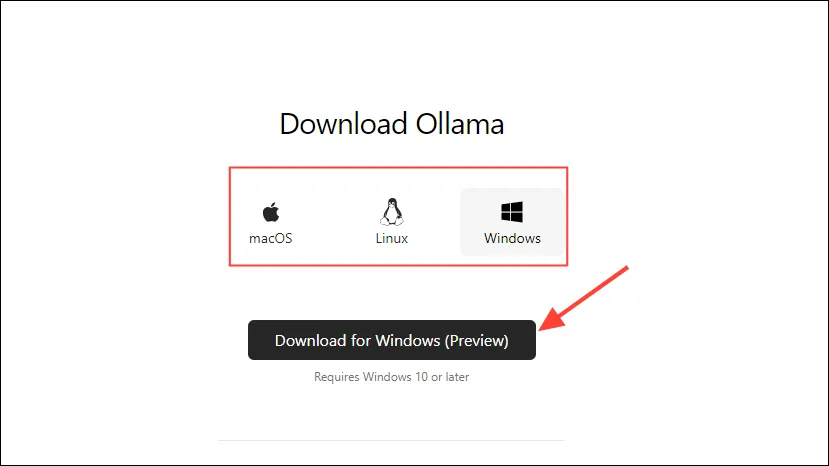

Scaricare e installare Ollama

- Per prima cosa, visita la pagina di download di Ollama e seleziona il tuo sistema operativo prima di cliccare sul pulsante “Download”.

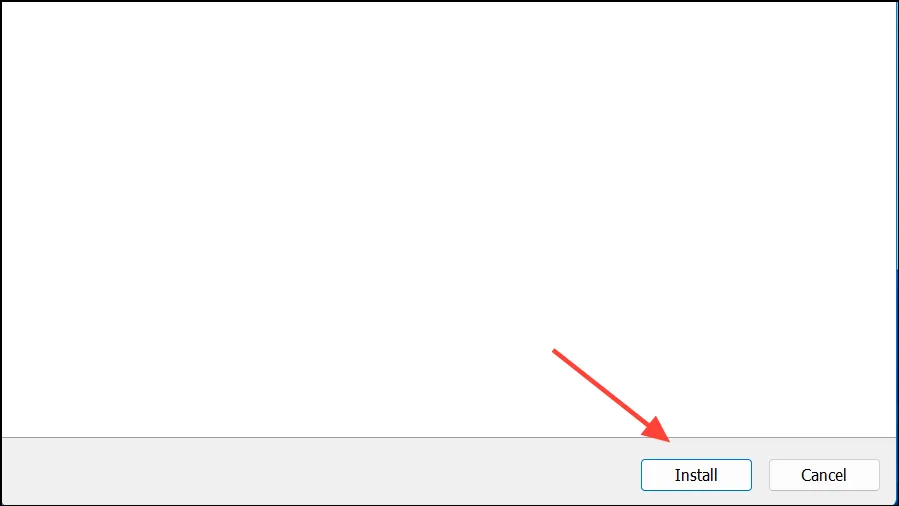

- Una volta completato il download, aprilo e installalo sul tuo computer. L’installer si chiuderà automaticamente al termine dell’installazione.

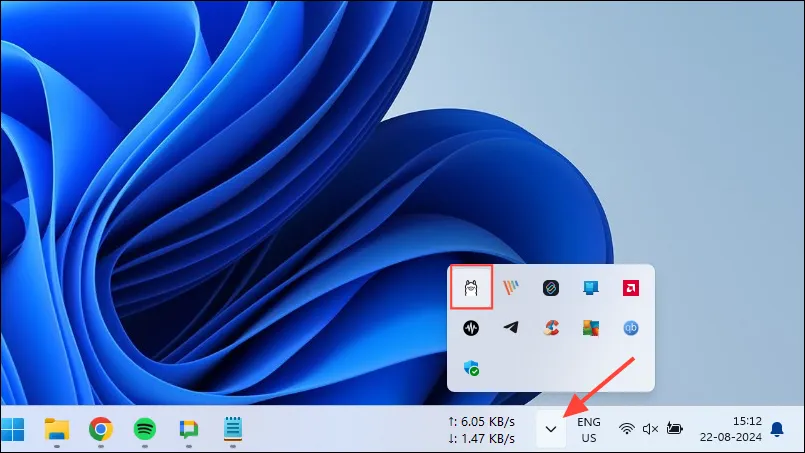

- Su Windows, puoi controllare se Ollama è in esecuzione o meno cliccando sul pulsante di overflow della barra delle applicazioni per visualizzare le icone nascoste.

Personalizzazione e utilizzo di Ollama

Una volta installato Ollama sul tuo computer, la prima cosa che dovresti fare è cambiare dove memorizza i suoi dati. Di default, la posizione di archiviazione è C:\Users\%username%\.ollama\modelsma poiché i modelli AI possono essere piuttosto grandi, la tua unità C può riempirsi rapidamente. Per farlo,

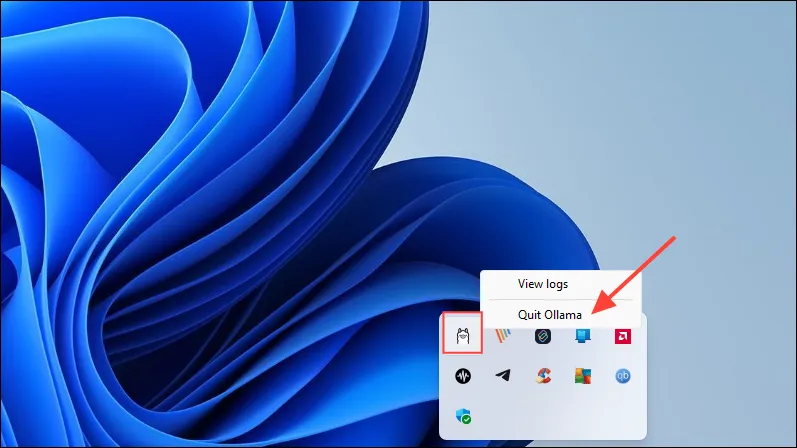

- Per prima cosa, clicca sull’icona di Ollama nella barra delle applicazioni e clicca su “Esci da Ollama”.

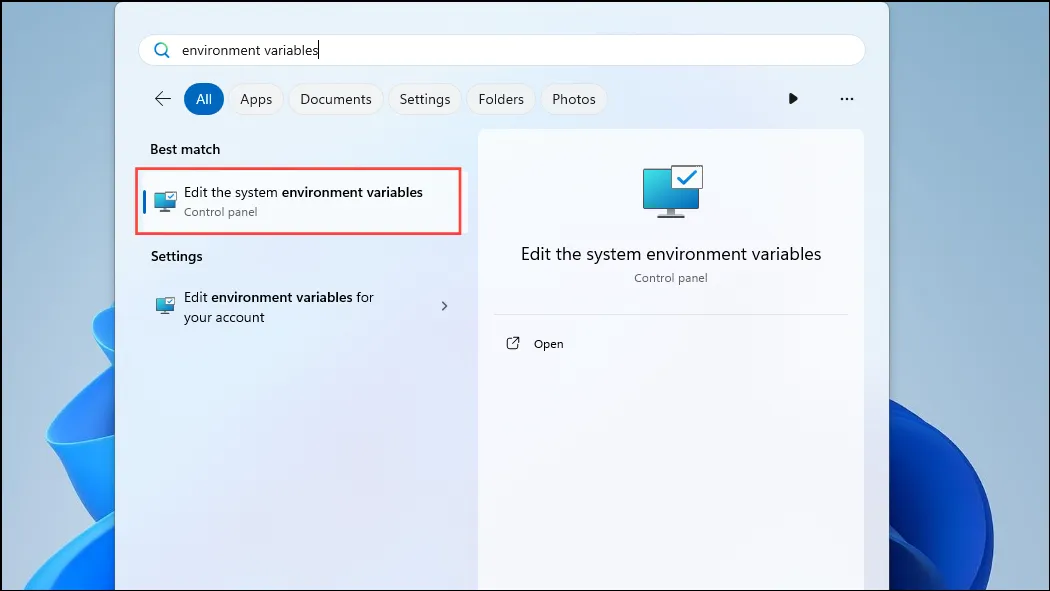

- Una volta chiuso Ollama, apri il menu Start, digita

environment variablese clicca su ‘Modifica variabili di ambiente di sistema’.

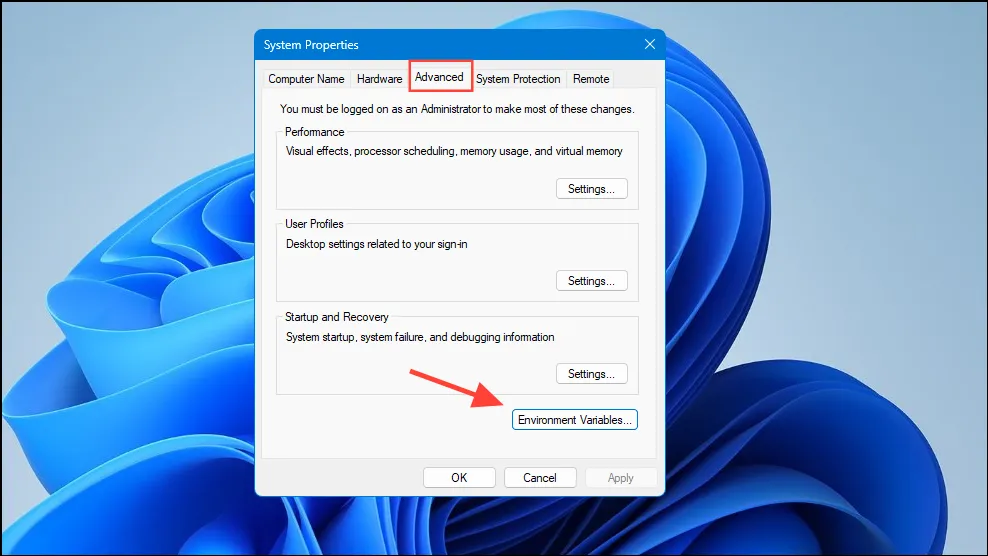

- Quando si apre la finestra di dialogo Variabili di sistema, fare clic sul pulsante “Variabili d’ambiente” nella scheda “Avanzate”.

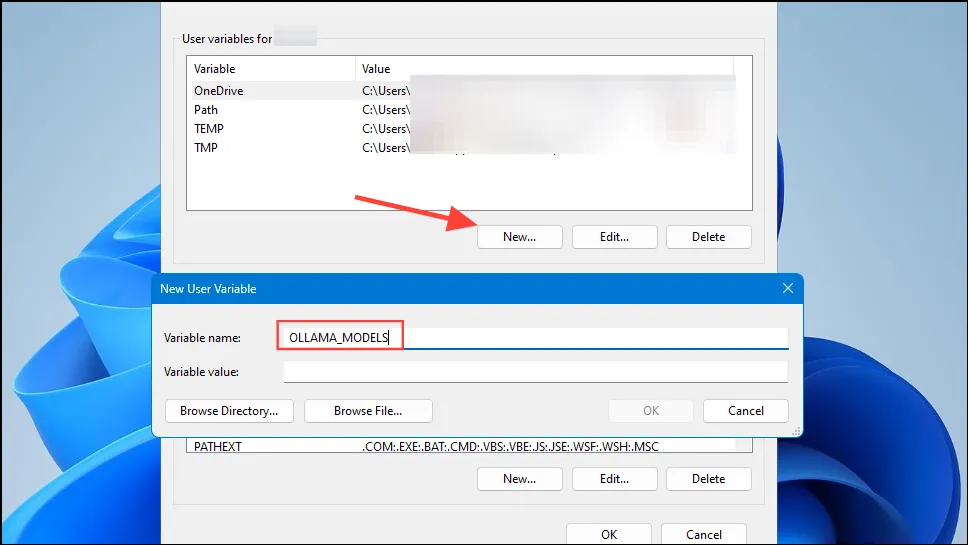

- Fai clic sul pulsante “Nuovo” per il tuo account utente e crea una variabile denominata

OLLAMA_MODELSnel campo “Nome variabile”.

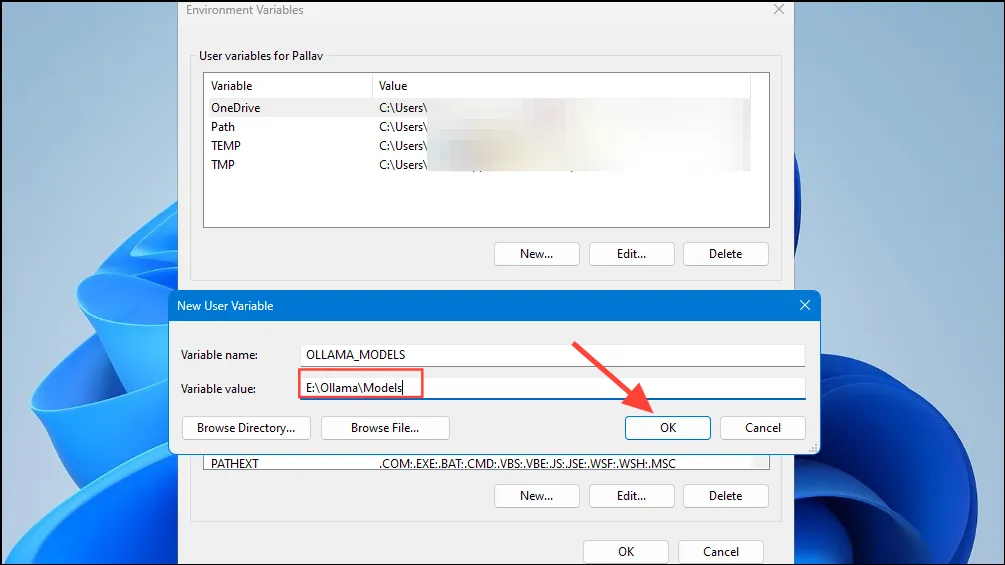

- Quindi digita la posizione della directory in cui vuoi che Ollama memorizzi i suoi modelli nel campo ‘Valore variabile’. Quindi fai clic sul pulsante ‘OK’ prima di avviare Ollama dal menu Start.

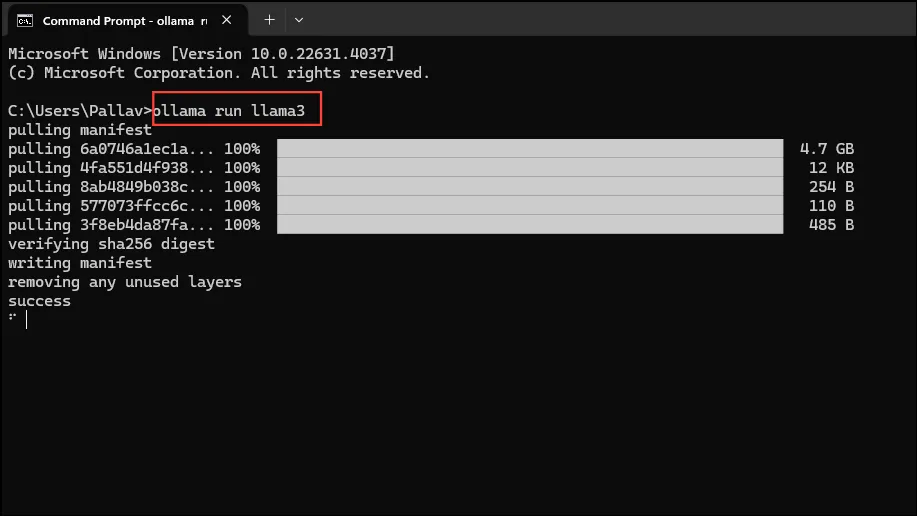

- Ora sei pronto per iniziare a usare Ollama, e puoi farlo con Llama 3 8B di Meta, l’ultimo modello di intelligenza artificiale open source dell’azienda. Per eseguire il modello, avvia un prompt dei comandi, Powershell o una finestra di Windows Terminal dal menu Start.

- Una volta aperta la finestra del prompt dei comandi, digita

ollama run llama3e premi Invio. Il modello è vicino ai 5 GB, quindi scaricarlo richiederà del tempo.

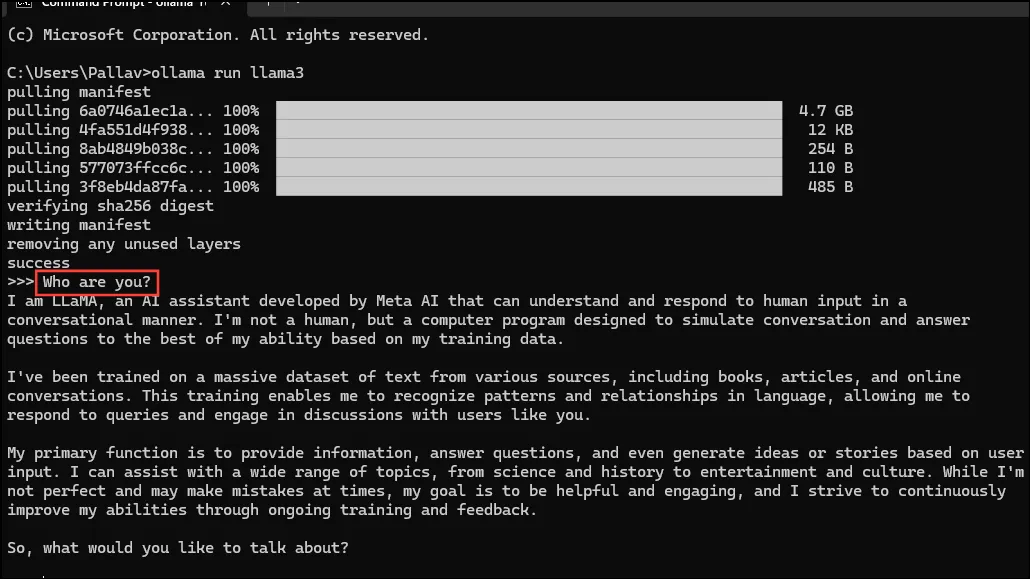

- Una volta completato il download, puoi iniziare a usare Llama 3 8B e conversare con lui direttamente nella finestra della riga di comando. Ad esempio, puoi chiedere al modello

Who are you?e premere Invio per ottenere una risposta.

- Ora puoi continuare la conversazione e porre domande ai modelli AI su vari argomenti. Tieni presente che Llama 3 può commettere errori e avere allucinazioni, quindi dovresti stare attento quando lo usi.

- Puoi anche provare altri modelli, visitando la pagina della libreria di modelli Ollama. Inoltre, ci sono vari comandi che puoi eseguire per provare diverse funzionalità offerte da Ollama.

- Durante l’esecuzione di un modello è inoltre possibile eseguire diverse operazioni, ad esempio impostare variabili di sessione, visualizzare informazioni sul modello, salvare una sessione e altro ancora.

- Ollama consente inoltre di sfruttare i modelli AI multimodali per riconoscere le immagini. Ad esempio, il modello LLava può riconoscere le immagini generate da DALLE-3. Può descrivere le immagini in dettaglio.

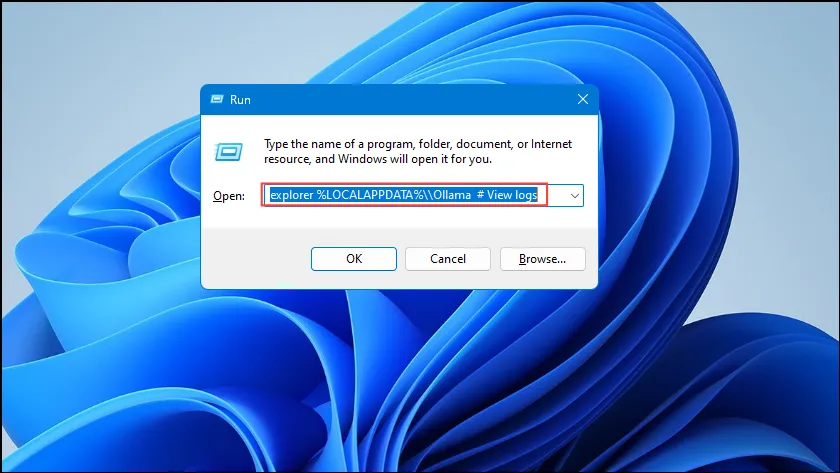

- Se riscontri errori durante l’esecuzione di Ollama, puoi controllare i log per scoprire qual è il problema. Utilizza la

Win + Rscorciatoia per aprire la finestra di dialogo Esegui e quindi digitaexplorer %LOCALAPPDATA%\\Ollama # View logsal suo interno prima di premere Invio.

- È possibile utilizzare anche altri comandi come

explorer %LOCALAPPDATA%\\Programs\\Ollamaeexplorer %HOMEPATH%\\.ollamaper controllare i file binari, il modello e la posizione di archiviazione della configurazione.

Cose da sapere

- Ollama rileva automaticamente la tua GPU per eseguire modelli AI, ma nelle macchine con più GPU, può selezionare quella sbagliata. Per evitare ciò, apri il pannello di controllo Nvidia e imposta Display su ‘Solo GPU Nvidia’.

- La modalità di visualizzazione potrebbe non essere disponibile su tutti i computer e risulta assente anche quando si collega il computer a display esterni.

- Su Windows, puoi verificare se Ollama sta utilizzando la GPU corretta tramite Task Manager, che mostrerà l’utilizzo della GPU e ti farà sapere quale è in uso.

- Sebbene l’installazione di Ollama su macOS e Linux sia leggermente diversa rispetto a Windows, il processo di esecuzione degli LLM è piuttosto simile.

Lascia un commento