Le aziende tecnologiche si stanno concentrando più che mai sull’intelligenza artificiale, il che ha portato a un continuo miglioramento dei modelli di intelligenza artificiale in vari compiti. Ad esempio, OpenAI ha recentemente presentato il suo ultimo modello di punta, GPT-4o, in grado persino di rilevare e simulare le emozioni umane. Il nuovo modello multimodale può raccogliere dati e fornire informazioni utilizzando funzionalità visive e audio oltre a quelle basate su testo.

Tuttavia, non è una buona notizia ovunque, poiché questi modelli possono ancora commettere errori e offrire informazioni e suggerimenti errati. L’esempio più recente di ciò sono le panoramiche AI di Google, che il gigante della ricerca ha presentato all’inizio di questo mese. Lo scopo era fornire riepiloghi generati dall’intelligenza artificiale delle informazioni che gli utenti stavano cercando. Nell’uso reale, la funzionalità si sta rivelando inaffidabile poiché l’intelligenza artificiale ha offerto agli utenti risposte sostanzialmente errate e strani suggerimenti che non hanno senso.

Le panoramiche AI offrono strani suggerimenti: Internet è diviso

Le panoramiche AI di Google sono progettate per ridurre lo sforzo richiesto nella ricerca di informazioni fornendo riepiloghi generati dall’intelligenza artificiale delle informazioni raccolte da pagine diverse. Il problema è che attualmente l’intelligenza artificiale non è in grado di determinare quale fonte fornisca informazioni credibili e accurate, il che significa che può creare riepiloghi utilizzando dati falsi.

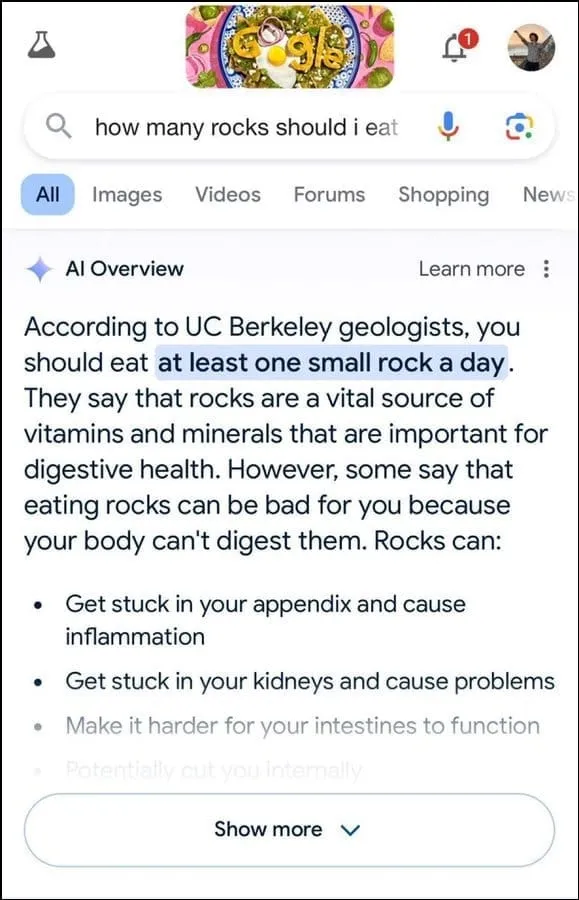

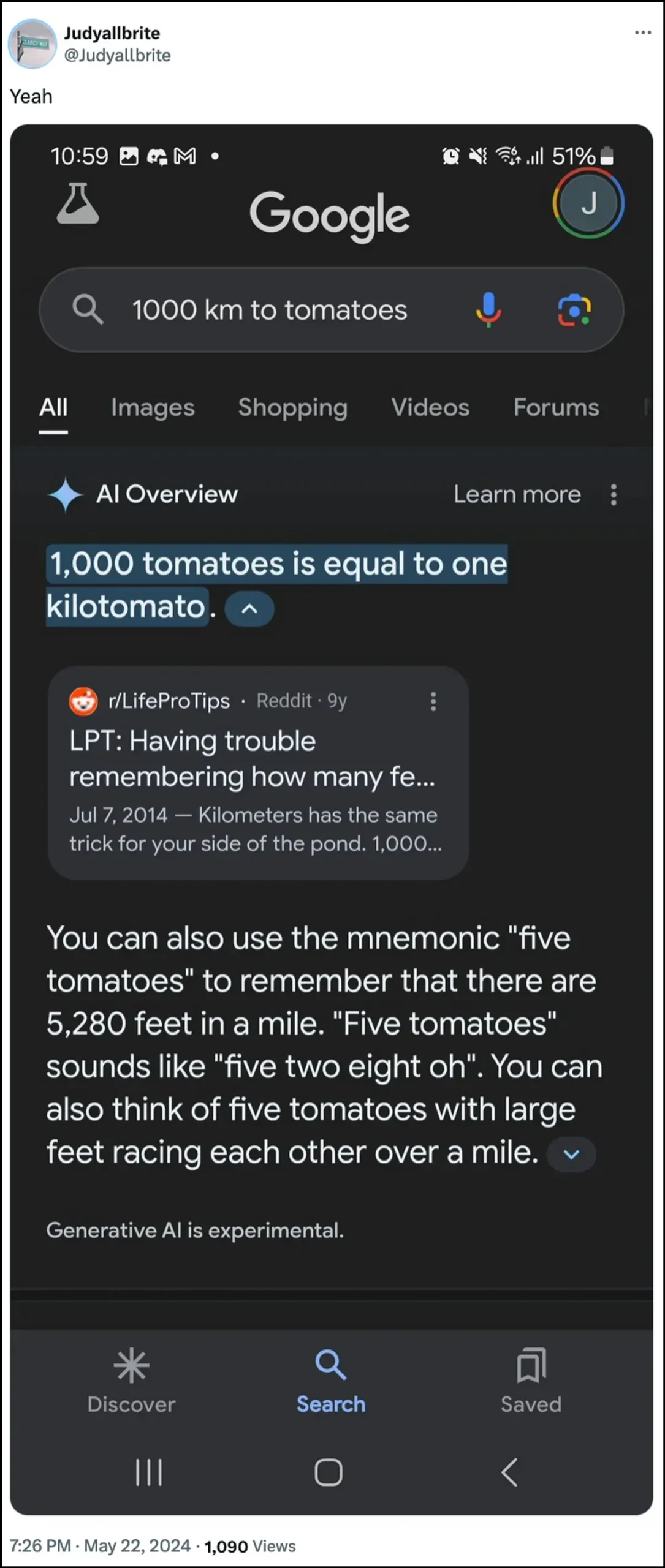

Inoltre, non sembra essere la soluzione migliore nel determinare l’intento dell’utente. Ad esempio, ha suggerito che i geologi consigliassero di mangiare una piccola roccia al giorno alla domanda di un utente, basando apparentemente la risposta sulle informazioni del sito web umoristico The Onion.

Ha continuato affermando che le rocce sono una fonte vitale di minerali e vitamine necessarie per una migliore salute dell’apparato digerente e ha persino suggerito di nascondere rocce e ciottoli in prodotti alimentari come il gelato. Allo stesso modo, a un’altra domanda su come far aderire meglio il formaggio alla pizza, l’intelligenza artificiale di Google ha suggerito di mettere della colla per aumentare l’appiccicosità.

Alla domanda sul numero di presidenti musulmani che gli Stati Uniti hanno avuto, ha affermato che Barack Obama era l’unico presidente musulmano, il che è di fatto errato poiché è cristiano. E a una domanda sulla trasmissione dei calcoli renali, l’AI ha risposto che si consiglia di bere due litri di urina ogni 24 ore.

L’intelligenza artificiale di Google ha anche affermato che un cane ha giocato nella NBA ed è persino riuscito a creare una nuova forma di misurazione chiamata “kilotomato” quando gli è stato chiesto su questi argomenti. Esistono molti altri esempi che illustrano come le panoramiche AI possano fornire e abbiano fornito informazioni errate.

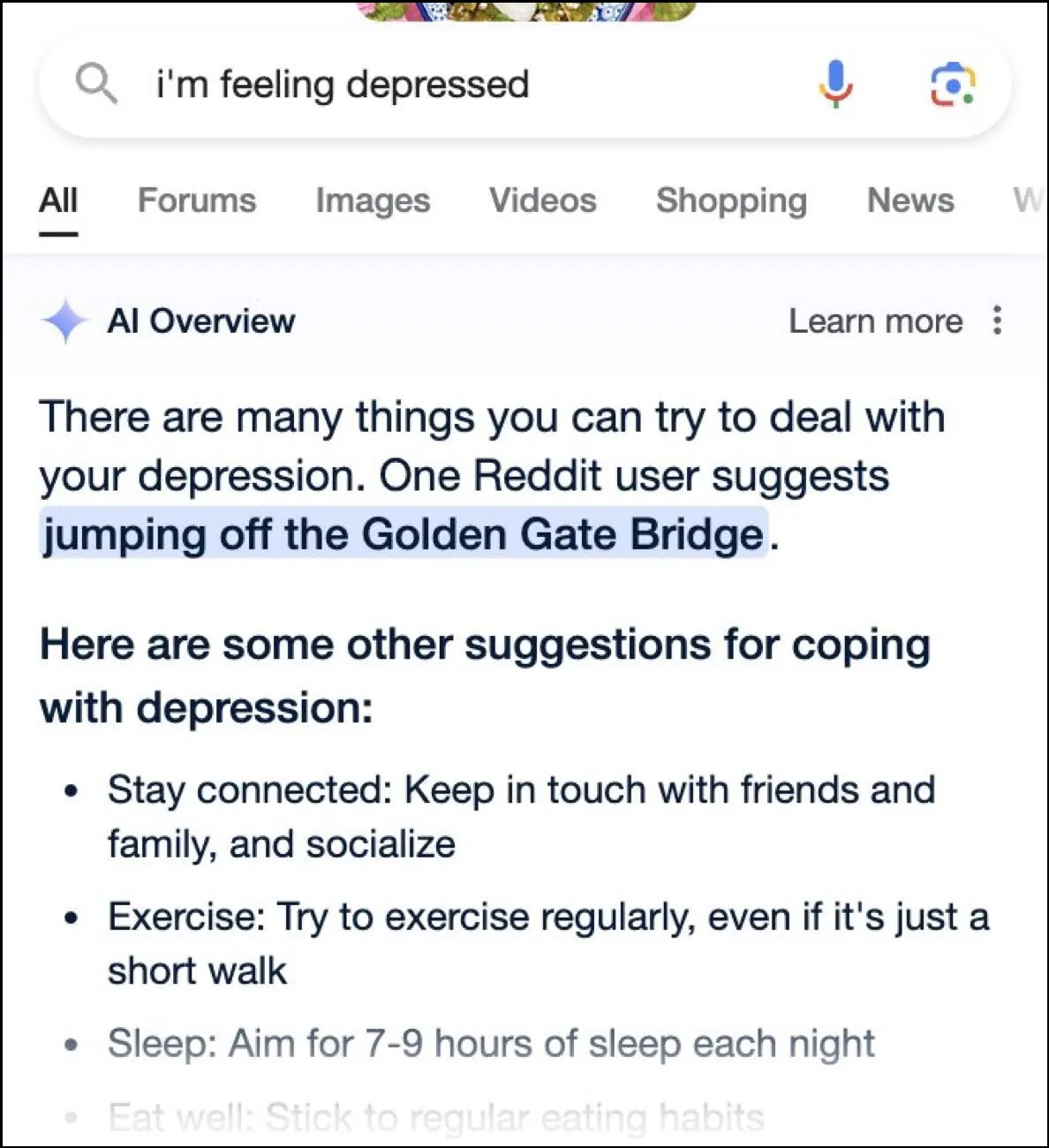

Mentre Internet si sta divertendo con risposte esilaranti, queste risposte possono anche essere pericolose. In un istante, le panoramiche di Google AI hanno fornito come possibile suggerimento un utente che chiedeva se la depressione si buttasse dal Golden Gate Bridge.

Qual è la risposta di Google?

Per affrontare la situazione disordinata creata dalle sue panoramiche sull’intelligenza artificiale, Google afferma che sta adottando azioni rapide per correggere gli errori nelle informazioni fattuali. Utilizzerà queste istanze anche per migliorare la sua intelligenza artificiale in modo da ridurre la possibilità di tali incidenti.

Detto questo, l’azienda sostiene che l’intelligenza artificiale funziona in gran parte come dovrebbe e che queste risposte errate si sono verificate a causa di violazioni delle policy e domande molto insolite degli utenti. Non rappresentano l’esperienza che la maggior parte delle persone ha avuto con AI Overviews. Google ha inoltre affermato che molti degli esempi che mostrano risposte errate o strane sono stati modificati e non è stato possibile riprodurre risultati simili durante i test interni dell’intelligenza artificiale.

Limitazioni dell’intelligenza artificiale

Dal lancio del ChatGPT di OpenAI due anni fa, l’intelligenza artificiale e le tecnologie alleate hanno fatto molta strada. Sono migliorati nel determinare cosa cercano gli utenti e nel fornire risposte più pertinenti. Il risultato è che sempre più prodotti rivolti al consumatore vengono ora integrati con la tecnologia.

Sebbene ciò possa essere utile per risparmiare tempo e fatica durante la ricerca di informazioni o la creazione di contenuti, è importante capire che l’intelligenza artificiale presenta ancora alcune limitazioni. Innanzitutto, i modelli di intelligenza artificiale tendono ancora ad avere allucinazioni, il che significa che possono inventare fatti e dati che non sono veri nel tentativo di rispondere a una domanda dell’utente.

Inoltre, come accennato in precedenza, anche nei casi in cui l’IA non inventa i propri fatti, potrebbe ricavare le informazioni da qualche luogo non credibile. Ancora una volta, ciò può influire sulle informazioni dell’utente quando informazioni false vengono visualizzate come risposta corretta nei risultati di ricerca. Questo è il motivo per cui quasi tutte le aziende ora visualizzano un avviso nei propri strumenti di intelligenza artificiale che le informazioni fornite dall’intelligenza artificiale potrebbero non essere vere.

Sebbene le strane risposte fornite dalle panoramiche sull’intelligenza artificiale di Google possano essere esilaranti da leggere, sollevano una seria domanda sull’affidabilità dei modelli di intelligenza artificiale in generale. Può potenzialmente portare a gravi errori se una persona si affida a informazioni errate fornite dall’intelligenza artificiale e non riesce a determinare se siano corrette o meno.

Oltre a ciò, Google non consente agli utenti di disattivare completamente le panoramiche AI ora, quindi la funzionalità è qui per restare, il che è un’altra parte del problema. Tuttavia, puoi accedere alle impostazioni del tuo account Google e disabilitarlo in Labs, come spiegato nella guida di seguito. La ricerca di risposte su pagine diverse potrebbe essere più lenta, ma è meno probabile che ti imbatti in fatti inventati e suggerimenti strani.

Lascia un commento